Description

Les modèles linguistiques modernes à grande échelle (LLM) sont de plus en plus utilisés dans les domaines de l'éducation [11, 2], de la santé [12], des systèmes de recommandation [5, 20] et dans d'autres domaines ; ils sont souvent utilisés par des utilisateurs ayant des compétences techniques limitées. Si cela démocratise l'accès à l'IA, de nombreuses recherches ont montré que ces modèles présentent des biais importants [7, 8, 13] qui varient selon les tâches [15, 18, 19] et les contextes culturels [1, 14]. Il existe des méthodes de détection et d'atténuation des biais [9], mais elles sont coûteuses en termes de calcul [4, 6, 9, 16], ce qui crée une fracture en matière d'équité. Si l'accès à l'IA est démocratisé, l'accès à l'équité et à la sécurité de l'IA ne l'est pas, car de nombreux utilisateurs d'IA ne disposent pas des ressources nécessaires pour évaluer et atténuer de manière exhaustive les biais.

Ce projet vise directement cette fracture en matière d'équité, avec pour objectif de développer des techniques d'évaluation et d'atténuation des biais à faible coût, utilisables par des organisations disposant de petits budgets, et contribue ainsi à la démocratisation de l'équité de l'IA. Nous définissons les ressources limitées non pas par la disponibilité des données pour une langue spécifique, mais par un ensemble de contraintes techniques : coût informatique minimal, accès minimal au modèle, modifications minimales du modèle et main-d'œuvre humaine minimale. Le caractère innovant de cette recherche réside dans l'accent mis sur les environnements à ressources limitées et dans le compromis à trois volets entre le coût de l'atténuation, la réduction des biais et la précision des tâches (une lacune dans la recherche actuelle). Ce projet permettra : i) de développer des méthodes d'évaluation de type « boîte noire » à faible coût, en les comparant à des alternatives plus coûteuses en termes de calcul, ii) de quantifier la courbe de performance par coût de calcul pour l'atténuation des biais dans différentes tâches, iii) d'identifier les compromis optimaux pour les techniques d'atténuation à faible coût.

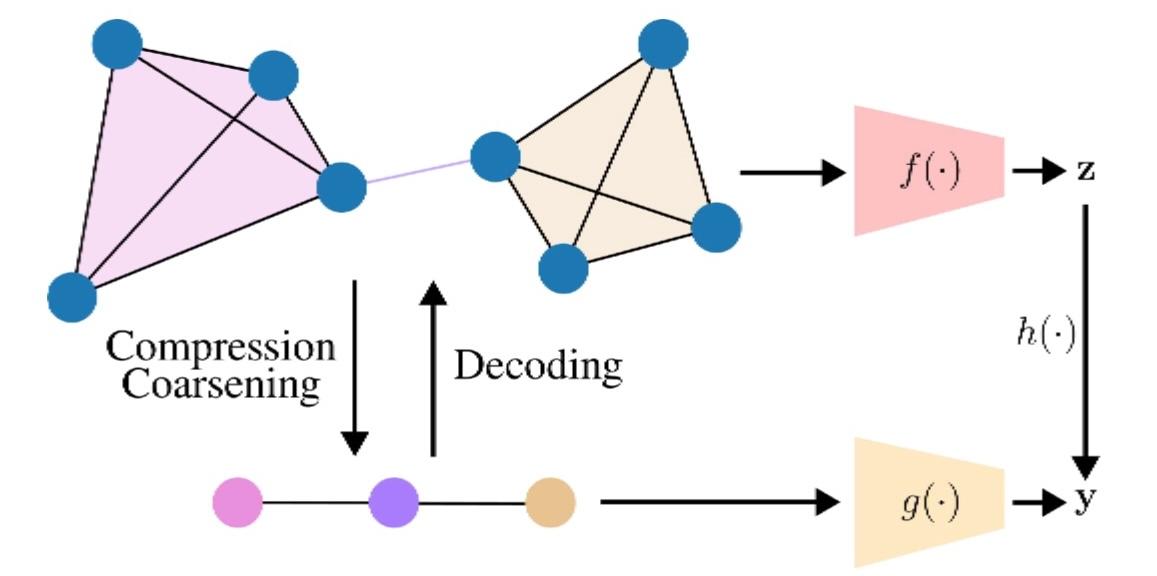

Le résultat principal sera une boîte à outils d'équité à faibles ressources, fournissant aux utilisateurs de l'IA les outils nécessaires pour évaluer et atténuer les biais à faibles ressources dans leurs domaines d'application et leurs tâches. Nous nous concentrerons principalement sur les modèles de type « boîte noire », en utilisant à la fois des modèles commerciaux (qui représentent le scénario d'adoption de l'IA le plus courant) et des modèles à poids ouverts. Dans ce contexte, il n'y a pas d'accès aux états internes des modèles, ce qui constitue un obstacle important pour les audits d'IA [3]. Pour la détection des biais, nous cherchons à surmonter cet obstacle en nous inspirant de la psychométrie, en modélisant les biais observés comme des traits latents (analogues aux compétences dans la théorie de la réponse à l'item [10]) et en les mesurant à l'aide d'un test stratégique (analogue au test adaptatif informatisé [17]). Pour l'atténuation, nous nous concentrerons sur des méthodes sans formation, pouvant être mises en œuvre avant l'inférence (édition des entrées) ou après l'inférence (édition des sorties), dans le but de proposer une alternative légère aux techniques d'alignement coûteuses.

Une fois terminée, cette boîte à outils permettra aux utilisateurs d'IA d'évaluer la sécurité des modèles d'IA dans leurs domaines avec des ressources limitées, favorisant ainsi la démocratisation d'une IA sûre plutôt que d'une IA dangereuse.

Bibliographie

Bibliographie

[1] Badr Alkhamissi, Muhammad ElNokrashy, Mai Alkhamissi, and Mona Diab. Investigating cultural alignment of large language models. In Proceedings of the 62nd Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), pages 12404–12422, 2024.

[2] Andrew Caines, Luca Benedetto, Shiva Taslimipoor, Christopher Davis, Yuan Gao, Øistein E Andersen, Zheng Yuan, Mark Elliott, Russell Moore, Christopher Bryant, et al. On the application of large language models for language teaching and assessment technology. In LLM@ AIED, 2023.

[3] Stephen Casper, Carson Ezell, Charlotte Siegmann, Noam Kolt, Taylor Lynn Curtis, Benjamin Bucknall, Andreas Haupt, Kevin Wei, Jérémy Scheurer, Marius Hobbhahn, et al. Black-box access is insufficient for rigorous ai audits. In Proceedings of the 2024 ACM Conference on Fairness, Accountability, and Transparency, pages 2254–2272, 2024.

[4] Sam Corbett-Davies, Emma Pierson, Avi Feller, Sharad Goel, and Aziz Huq. Algorithmic decision making and the cost of fairness. In Proceedings of the 23rd acm sigkdd international conference on knowledge discovery and data mining, pages 797–806, 2017.

[5] Sunhao Dai, Ninglu Shao, Haiyuan Zhao, Weijie Yu, Zihua Si, Chen Xu, Zhongxiang Sun, Xiao Zhang, and Jun Xu. Uncovering chatgpt’s capabilities in recommender systems. In Proceedings of the 17th ACM Conference on Recommender Systems, pages 1126–1132, 2023.

[6] MaryBeth Defrance, Maarten Buyl, and Tijl De Bie. Abcfair: an adaptable benchmark approach for comparing fairness methods. Advances in Neural Information Processing Systems, 37:40145–40163, 2024.

[7] Yashar Deldjoo. Understanding biases in chatgpt-based recommender systems: Provider fairness, temporal stability, and recency. ACM Transactions on Recommender Systems, 2024.

[8] Eve Fleisig, Genevieve Smith, Madeline Bossi, Ishita Rustagi, Xavier Yin, and Dan Klein. Linguistic Bias in ChatGPT: Language Models Reinforce Dialect Discrimination. In Yaser Al-Onaizan, Mohit Bansal, and Yun-Nung Chen, editors, Proceedings of the 2024 Conference on Empirical Methods in Natural Language Processing, pages 13541–13564, Miami, Florida, USA, November 2024. Association for Computational Linguistics.

[9] Isabel O Gallegos, Ryan A Rossi, Joe Barrow, Md Mehrab Tanjim, Sungchul Kim, Franck Dernoncourt, Tong Yu, Ruiyi Zhang, and Nesreen K Ahmed. Bias and fairness in large language models: A survey. Computational Linguistics, 50(3):1097–1179, 2024.

[10] Ronald K Hambleton, Hariharan Swaminathan, and H Jane Rogers. Fundamentals of item response theory, volume 2. Sage, 1991.

[11] Enkelejda Kasneci, Kathrin Seßler, Stefan Küchemann, Maria Bannert, Daryna Dementieva, Frank Fischer, Urs Gasser, Georg Groh, Stephan Günnemann, Eyke Hüllermeier, et al. Chatgpt for good? on opportunities and challenges of large language models for education. Learning and individual differences, 103:102274, 2023.

[12] Jianning Li, Amin Dada, Behrus Puladi, Jens Kleesiek, and Jan Egger. Chatgpt in healthcare: a taxonomy and systematic review. Computer Methods and Programs in Biomedicine, 245:108013, 2024.

[13] Weicheng Ma, Brian Chiang, Tong Wu, Lili Wang, and Soroush Vosoughi. Intersectional Stereotypes in Large Language Models: Dataset and Analysis. In Houda Bouamor, Juan Pino, and Kalika Bali, editors, Findings of the Association for Computational Linguistics: EMNLP 2023, pages 8589–8597, Singapore, December 2023. Association for Computational Linguistics.

[14] Reem Masoud, Ziquan Liu, Martin Ferianc, Philip C Treleaven, and Miguel Rodrigues Rodrigues. Cultural alignment in large language models: An explanatory analysis based on hofstede’s cultural dimensions. In Proceedings of the 31st International Conference on Computational Linguistics, pages 8474–8503, 2025.

[15] Huy Nghiem, John Prindle, Jieyu Zhao, and Hal Daumé Iii. “you gotta be a doctor, lin”: An investigation of name-based bias of large language models in employment recommendations. In Proceedings of the 2024 Conference on Empirical Methods in Natural Language Processing, pages 7268–7287, 2024.

[16] Ricardo Trainotti Rabonato and Lilian Berton. A systematic review of fairness in machine learning. AI and Ethics, 5(3):1943–1954, 2025.

[17] Mark D Reckase. Computerized adaptive testing: A good idea waiting for the right technology. 1988.

[18] Iain Weissburg, Sathvika Anand, Sharon Levy, and Haewon Jeong. LLMs are Biased Teachers: Evaluating LLM Bias in Personalized Education, February 2025.

[19] Kyra Wilson and Aylin Caliskan. Gender, Race, and Intersectional Bias in Resume Screening via Language Model Retrieval, August 2024.

[20] Zihuai Zhao, Wenqi Fan, Jiatong Li, Yunqing Liu, Xiaowei Mei, Yiqi Wang, Zhen Wen, Fei Wang, Xiangyu Zhao, Jiliang Tang, et al. Recommender systems in the era of large language models (llms). IEEE Transactions on Knowledge and Data Engineering, 36(11):6889–6907, 2024.