Description

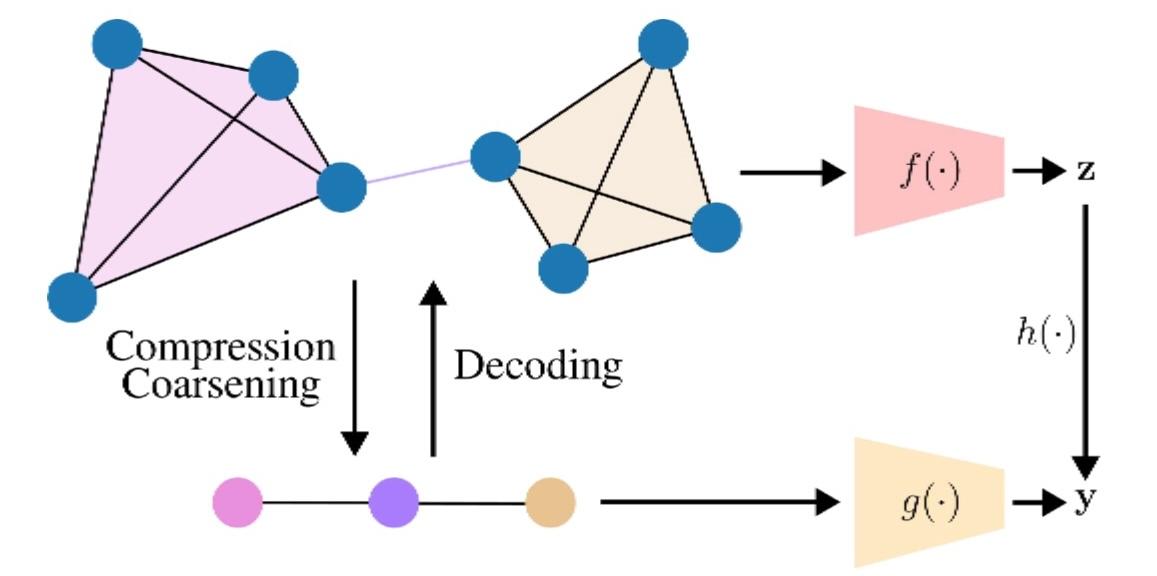

Les maladies cardiovasculaires restent la principale cause de mortalité dans le monde (OMS, 2019). En particulier, les maladies coronariennes nécessitent souvent un pontage aorto-coronarien, une intervention hautement technique qui requiert plus de 15 ans de formation et s'appuie sur des laboratoires humides, des simulateurs et l'observation directe en salle d'opération. Ces méthodes de formation traditionnelles souffrent d'une disponibilité, d'une reproductibilité et d'une interactivité limitées. Ce projet propose une rupture technologique et méthodologique pour surmonter ces limites, en s'appuyant sur la fertilisation croisée entre les technologies immersives (permettant des expériences de formation sûres, reproductibles et personnalisées [1]) et génératives (création de contenus visuels et artificiels personnalisés [2], [3], [4]) pour la chirurgie cardiaque. L'objectif est de concevoir un jumeau numérique génératif de la chirurgie cardiaque, capable de reconstruire [4], simuler [5], [6] et enrichir les interventions chirurgicales réelles pour une formation immersive et adaptative [7], [8]. À cette fin, l'ambition principale est de créer un environnement virtuel contrôlable généré à partir de données multimodales réelles (vidéos, profondeur, mouvement et son) combinées à une IA générative texte-3D [2], [9], [10]. Le système permettra aux stagiaires de visualiser, d'interagir et de répéter des gestes chirurgicaux dans une réalité étendue, tout en s'adaptant dynamiquement à l'expertise de l'utilisateur ou aux variations de scénario.

L'introduction de la modélisation générative pour transcender les limites des simulateurs artisanaux actuels et des expériences scriptées comporte plusieurs défis. Actuellement, l'utilisation de la réalité étendue (XR) en chirurgie cardiaque reste limitée aux jeux sérieux ou à la téléportation [1] en raison du manque de données publiques disponibles sur la chirurgie ouverte [8], [11]. Ensuite, les méthodes de vision par ordinateur et d'IA générative utilisées pour reconstruire et analyser des scènes 3D dynamiques peuvent être limitées par des contraintes telles que les tissus déformables, les occlusions et la variabilité de l'éclairage [6], [12], [13]. À cette fin, il s'appuiera sur les progrès récents en matière de représentations neuronales de scènes [9] et de rendu différentiable basé sur des points [13], en combinant des approches de modélisation implicites et explicites [3] avec une diffusion générative de texte vers 3D, afin de produire des environnements sémantiquement contrôlables et anatomiquement fidèles [2], [10], [14], [15]. À moyen terme, nous serons en mesure de générer automatiquement des scénarios réalistes et personnalisables à partir de suggestions textuelles et d'images, tout en tenant compte des contraintes précédentes [6].

Le projet implique plusieurs acteurs spécialisés dans (i) la vision par ordinateur et la RV/RA (ARMEDIA, SAMOVAR, Télécom SudParis) ; (ii) les modèles d'IA générative (SOP, SAMOVAR, Télécom SudParis) et (iii) la chirurgie cardiaque avec une expertise en XR (Pr. Patrick Nataf, INSERM). Par conséquent, une base de données du point de vue du chirurgien a déjà été partiellement acquise. Le doctorant étendra et optimisera le dispositif de capture, développera des pipelines de prétraitement et d'annotation (segmentation, résumé, description, ontologie médicale), affinera et mettra en œuvre des modèles génératifs pour la reconstruction et la synthèse de scènes, et développera un moteur de génération 3D multimodal basé sur des invites pour les scénarios chirurgicaux. Le résultat attendu est un simulateur de formation cardiaque basé sur l'IA et intégré aux infrastructures XR existantes de l'INSERM. Les différentes équipes ont été contactées par P. Spinga, ancien étudiant de Télécom SudParis, classé 16e sur 195 (1re année) et 8e sur 241 (2e année) et ancien ingénieur de recherche chez Dassault Systèmes - département Santé.

En conclusion, cette recherche vise à ouvrir la voie à un jumeau numérique complet de la chirurgie cardiaque, un compagnon cognitif et perceptif qui pourrait un jour assister les chirurgiens avant, pendant et après les interventions, transformant à la fois l'enseignement médical et l'avenir de la chirurgie elle-même [7].

Bibliographie

Bibliographie

[1] M. Queisner, C. Remde, et M. Pogorzhelskiy, « VolumetricOR: A New Approach to Simulate Surgical Interventions in Virtual Reality for Surgical Education », 18 octobre 2019, Humboldt- Universität zu Berlin. doi: 10.18452/20470.

[2] T. Yi et al., « GaussianDreamer: Fast Generation from Text to 3D Gaussians by Bridging 2D and 3D Diffusion Models », 13 mai 2024, arXiv: arXiv:2310.08529. doi: 10.48550/arXiv.2310.08529.

[3] P. Pan et al., « Diff4Splat: Controllable 4D Scene Generation with Latent Dynamic Reconstruction Models », 1 novembre 2025, arXiv: arXiv:2511.00503. doi: 10.48550/arXiv.2511.00503.

[4] B. G. A. Gerats, J. M. Wolterink, et I. A. M. J. Broeders, « NeRF-OR: neural radiance fields for operating room scene reconstruction from sparse-view RGB-D videos », Int J CARS, vol. 20, no 1, p. 147‑156, sept. 2024, doi: 10.1007/s11548-024-03261-5.

[5] Z. Yang, K. Chen, Y. Long, et Q. Dou, « SimEndoGS: Efficient Data-driven Scene Simulation using Robotic Surgery Videos via Physics-embedded 3D Gaussians », 6 août 2024, arXiv: arXiv:2405.00956. doi: 10.48550/arXiv.2405.00956.

[6] Y. Wang, B. Gong, Y. Long, S. H. Fan, et Q. Dou, « Efficient EndoNeRF Reconstruction and Its Application for Data-driven Surgical Simulation », 10 avril 2024, arXiv: arXiv:2404.15339. doi: 10.48550/arXiv.2404.15339.

[7] Z. Rudnicka, K. Proniewska, M. Perkins, et A. Pregowska, « Health Digital Twins Supported by Artificial Intelligence-based Algorithms and Extended Reality in Cardiology », Electronics, vol. 13, no 5, p. 866, févr. 2024, doi: 10.3390/electronics13050866.

[8] Y. Frisch et al., « SurGrID: Controllable Surgical Simulation via Scene Graph to Image Diffusion », Int J CARS, vol. 20, no 7, p. 1421‑1429, mai 2025, doi: 10.1007/s11548-025-03397-y.

[9] J. Zhang, X. Li, Z. Wan, C. Wang, et J. Liao, « Text2NeRF: Text-Driven 3D Scene Generation with Neural Radiance Fields », 31 janvier 2024, arXiv: arXiv:2305.11588. doi: 10.48550/arXiv.2305.11588.

[10] J. Shriram, A. Trevithick, L. Liu, et R. Ramamoorthi, « RealmDreamer: Text-Driven 3D Scene Generation with Inpainting and Depth Diffusion », 11 mars 2025, arXiv: arXiv:2404.07199. doi: 10.48550/arXiv.2404.07199.

[11] T. Zeng, G. L. Galindo, J. Hu, P. Valdastri, et D. Jones, « Realistic Surgical Image Dataset Generation Based On 3D Gaussian Splatting », 20 juillet 2024, arXiv: arXiv:2407.14846. doi: 10.48550/arXiv.2407.14846.

[12] A. Lou, Y. Li, X. Yao, Y. Zhang, et J. Noble, « SAMSNeRF: Segment Anything Model (SAM) Guides Dynamic Surgical Scene Reconstruction by Neural Radiance Field (NeRF) », 6 février 2024, arXiv: arXiv:2308.11774. doi: 10.48550/arXiv.2308.11774.

[13] A. Guédon et V. Lepetit, « SuGaR: Surface-Aligned Gaussian Splatting for Efficient 3D Mesh Reconstruction and High-Quality Mesh Rendering », 2 décembre 2023, arXiv: arXiv:2311.12775. doi: 10.48550/arXiv.2311.12775.

[14] Y. Huang et al., « SurgTPGS: Semantic 3D Surgical Scene Understanding with Text Promptable Gaussian Splatting », 1 juillet 2025, arXiv: arXiv:2506.23309. doi: 10.48550/arXiv.2506.23309.

[15] U. Singer et al., « Text-To-4D Dynamic Scene Generation